近日,華為與山東能源集團聯合宣布,在礦山領域成功實現人工智能應用軟件的落地,并開創了一種創新的工廠化開發模式。這一合作標志著傳統礦業在數字化轉型中邁出了關鍵一步,為行業智能化升級提供了可復制的樣板。

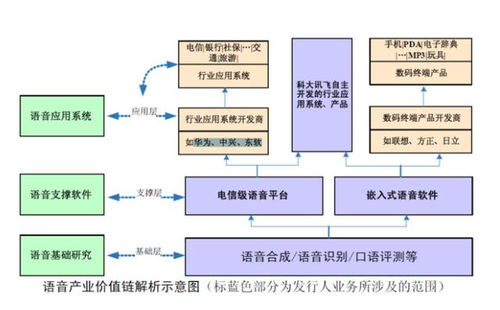

礦山行業歷來面臨高風險、低效率和環境挑戰。華為與山東能源集團的合作,聚焦于將AI技術深度整合到礦山運營中。通過部署智能感知、數據分析與自動化控制系統,AI應用軟件能夠實時監測礦井安全狀況、優化資源開采流程,并提升設備維護的精準性。例如,AI驅動的預測性維護系統可提前識別設備故障,減少停機時間;而智能調度算法則能優化運輸路線,降低能耗。這些應用不僅提高了生產效率,還顯著增強了工作安全性。

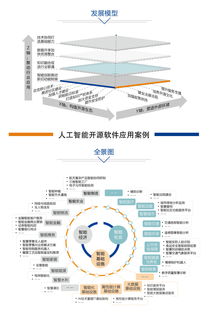

值得注意的是,這次合作開創了'工廠化開發模式',即通過標準化、模塊化的方式快速開發和部署AI軟件。這種模式借鑒了工業流水線理念,將AI應用拆分為可復用的組件,實現高效迭代和規模化推廣。它解決了傳統定制開發周期長、成本高的問題,讓礦山企業能夠根據實際需求靈活組合功能模塊。例如,山東能源集團在多個礦區試點中,利用該模式快速部署了智能監控和數據分析工具,縮短了實施時間,降低了技術門檻。

這一合作不僅限于技術落地,還推動了產業鏈協同。華為提供底層算力、算法平臺和5G通信支持,而山東能源集團貢獻了豐富的行業數據和應用場景。雙方通過共建實驗室和培訓機制,培養了跨領域人才,確保了AI解決方案的可持續運營。據初步數據,該模式已在山東部分礦山實現生產效率提升15%以上,安全事故率下降20%。

華為與山東能源集團的合作模式有望復制到其他能源和重工業領域。隨著國家對智能化礦山和綠色發展的政策支持,這種工廠化AI開發模式或將成為行業標準,推動中國制造業向智能、高效、安全的方向轉型。挑戰依然存在,如數據隱私、技術適配性和人才短缺等,需要持續創新與協作來克服。

華為與山東能源集團的合作不僅是AI技術在礦山領域的一次成功實踐,更開創了高效的開發范式,為傳統行業數字化轉型注入了新動力。